Cryptolocker, DataLeak, DDoS, falsification d’informations sont autant de risques que la cybersécurité combat au quotidien. Mais que se passerait-il si votre Système d’Information s’appuyait sur des sources de données multiples, protéiforme et sans aucune notion de maîtrise ?

C’est le nouveau défi auquel les Directions SI et RSSI sont confrontés avec le Big Data.

Une entreprise disposant de volumes de données importants et variés a la possibilité de prendre des décisions plus précises et plus justes. Pour ce faire, le principe est de recouper les différentes données pour en extraire de nouvelles informations jusqu’alors inconnues.

Le Big Data va aller encore plus loin en permettant aux entreprises d’intégrer aux données recoupées des informations venant de sources extérieures, non maîtrisées par l’entreprise et bien souvent en large décalage avec son cœur de métier…

Par exemple, pour étudier la variabilité de la réussite d’une campagne marketing. Une agence de communication va intégrer les données météo à son étude et non seulement remarquer l’influence du soleil mais également du jour de lancement de la campagne au cours de la semaine.

Enjeux de sécurité liés à la gestion des données

Les risques cyber du Data Management

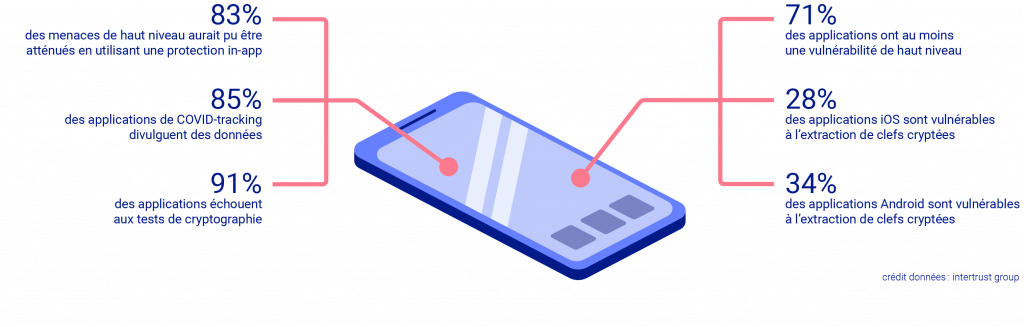

Les risques de fuite de données sont bien réels. Pour parler d’un sujet d’actualité, nous pouvons évoquer l’étude réalisée par Intertrust en octobre 2020. 100 applications de santé mobiles mondiales dont celles de suivi de la COVID-19 y ont été étudiées. Le résultat est le suivant : 71% des applications présentent au moins une vulnérabilité grave et 91% des applications échouent à un ou plusieurs tests cryptographiques. Cela signifie qu’il est possible, en cas d’attaque, d’avoir accès à des données confidentielles de patients, voire de les falsifier.

Pour ce qui est des cas réels, de nombreux exemples sont présents dans l’actualité récente. En 2018, la compagnie aérienne britannique « British Airways » a fait face à la fuite de 500 000 enregistrements clients dont environ 300 000 dossiers de cartes bancaires. En 2019, le plus gros vol de données a concerné deux entreprises d’enrichissement de données. Cet incident de cybercriminalité a permis la fuite de 4 milliards d’enregistrement de données personnelles et sans doute de grave conséquences pour les entreprises ayant fait l’objet de l’extorsion.

Pour éviter ce type d’évènements, il est nécessaire d’agir pour que la sécurisation des informations soit un prérequis et ne reste pas une simple option.

Les enjeux de protection des données sont d’autant plus important que le Big Data a tendance à regrouper une multitude d’informations qui peuvent permettre des recoupements révélant des informations qui se voulaient confidentielles.

Par exemple, lorsque des données pharmaceutiques anonymisées sont recoupées avec des données génétiques et des informations sur les habitudes alimentaires patients, la finalité médicale est évidemment pertinente. En revanche, le recoupement pourrait permettre de déduire des habitudes alimentaires en fonction des origines ethniques des personnes qui pourraient intéresser des groupes agroalimentaires.

Mesures à mettre en œuvre dans le cadre du Data Management

Les Entreprises travaillent à un changement d’approche en termes de sécurité des systèmes d’information. En effet, elles doivent passer d’un modèle de protection périmétrique, qui vise à protéger l’entreprise de l’extérieur en l’isolant, à une sécurité permettant une ouverture maîtrisée vers l’extérieur. Plus concrètement cela passe par la sécurisation des données et non plus seulement des infrastructures informatiques.

Ainsi, une des premières mesures à prendre en compte lors de la mise en œuvre d’usages des données, est de définir la valeur de ses données. Il est question de mener une démarche de classification des données, notamment d’un point de vue de leur confidentialité.

L’objectif de la classification des données est de savoir pour chaque information si elle est publique, interne à l’entreprise ou encore confidentielle à un certain nombre de collaborateurs.

En l’apparence, cette démarche peut sembler aisée mais en réalité, la sensibilité d’une donnée va être dépendante de la personne qui la définit. Les seules exceptions à cette complexité sont les données à caractère personnel pour lesquelles, depuis l’arrivée du RGPD, l’ensemble des entreprises ont bien appréhendé leur niveau de confidentialité. Pour réussir un projet de classification, celui-ci doit nécessairement impliquer différents métiers de l’entreprise et être porté par la Direction Générale.

Une fois la valeur des données définie, il faut définir qui peut les consulter. Les accès aux bases de données et aux plateformes de traitement des données doivent suivre la même logique que ceux aux applications internes fournissant les données. Pour y parvenir, il est nécessaire de définir des profils d’utilisation en fonction des usages envisagés ainsi qu’une politique de moindre privilège. Cette dernière vise à fournir à chaque collaborateur un accès aux seules données nécessaires à son activité.

Pour protéger les données des plateformes de gestion des données face à une cyberattaque, leur chiffrement peut être envisagé. Cependant, ce point fait débat car les processus de chiffrement et de déchiffrement allongent la durée de traitement des données et peuvent avoir des impacts techniques significatif. Cet allongement est infime pour une donnée mais devient important à l’échelle du Big Data et nécessite des expertises couteuses en informatique, en Data Management voire en mathématique et modélisation.

Du DataManagement au BigData : un changement conceptuel qui a son importance en termes de cybersécurité

Nous évoquions jusqu’alors les problématiques de confidentialité. En matière cyber, les risques de perte de données et/ou de leur intégrité sont aussi à prendre en compte. Le BigData démultiplie la encore les risques de piratage.

De façon simple, le recoupement des données visant à en retirer de nouvelles informations utiles au pilotage d’une entreprise – appelé Business Intelligence – s’appuie sur des données de sources multiples et hétérogènes. Un processus de traitement des données et de nombreux outils informatiques permettent l’acquisition des données, leur homogénéisation, leur traitement par des modèles d’analyse prédéfinis et enfin la représentation des informations créées sous forme d’indicateurs de pilotage ou de tableaux de bord.

Le Big Data introduit deux nuances importantes :

- La diversité de la nature des données : en plus des données de l’entreprise, il s’agit d’intégrer des données de sources qu’on ne maîtrise pas : données publiques (opendata), données importées en vracs, données collectées sur des sites webs, etc.

- Traitement de la donnée : compte-tenu de la nature souvent imprévisible des données, la BigData va s’appuyer sur des systèmes de traitement des données pouvant par exemple être basés sur l’intelligence artificielle. Dans ce cadre, les analyses ne sont pas produites par des modèles conçus par des analyste. C’est l’IA qui va essayer et faire ressortir des corrélations de façon opportuniste. Charge à l’analyste de valider ou d’invalider les corrélations.

Dans ce cadre, les analystes ne disposent ni d’une maîtrise des sources de données ni encore des modèles d’analyses employés par l’Intelligence Artificielle. Pour des structures disposants de moyens d’ingénierie avancés, il serait assez aisé de tromper les systèmes d’IA en altérant des sources de données faiblement sécurisées car a priori publiques et donc avec de faibles enjeux de sécurité.

Par exemple, l’étude et la compréhension de certains mécanisme d’analyse de Facebook auraient permis d’influer l’élection des Etats Unis d’Amérique en 2016 en créant artificiellement et imperceptiblement de la désinformation auprès de l’électorat. Ce type d’attaque pourrait s’appliquer sur des systèmes de prédiction boursiers, des études de marchés, etc.

Conclusion

En conclusion, il est primordial de bien protéger ses environnements big data, à la mesure du niveau de confidentialité des informations qui y sont corrélées. Cela permettra de protéger les serveurs mais se révèlera insuffisant en cas d’incident affectant la véracité des données sources.

La véracité, critère propre au Big Data, souligne la fiabilité des données exploitées. Elle est d’autant plus importante selon le niveau de maîtrise des sources de données utilisées.

Ainsi on pourrait imaginer demain une attaque par injection de fausses données visant à tromper les systèmes d’analyse, falsifier les résultats et donc la prise de décision. Pour éviter ou limiter l’impact de ce type d’attaque, il s’agit d’apporter une analyse supplémentaire. Celle-ci peut par exemple s’appuyer sur eBIOS Risk Manager (méthode d’analyse de risques développée par l’ANSSI) en considérant le ratio :

- Fiabilité et sécurité de la source de données

- Sources de risques : les organisations pouvant avoir un intérêt particulier à altérer les résultats et disposants de ressources pour y parvenir : concurrents, gouvernements, groupuscules terroristes, etc.